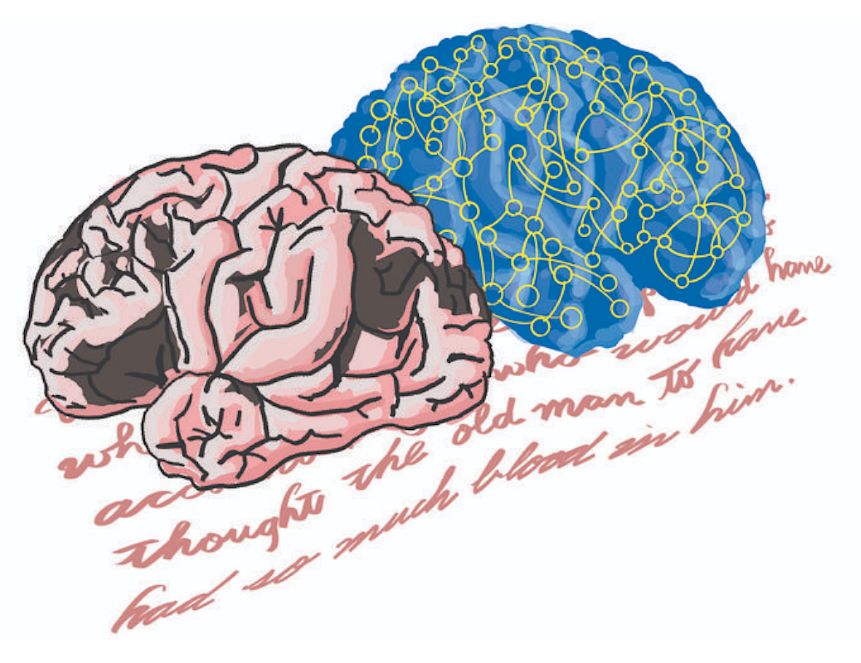

Японские ученые проанализировали работу больших языковых моделей и сравнили ее с активностью мозга людей с афазией — расстройством, при котором речь человека последовательна, но не имеет смысла. Оказалось, что ИИ и мозг с афазией работают по схожим механизмам. Это может объяснить, почему некоторые языковые модели быстро выдают неверную информацию. Исследование опубликовано в журнале Advanced Science.

Чат-боты и другие инструменты, основанные на искусственном интеллекте (ИИ), все больше участвуют в повседневной жизни людей. Большие языковые модели (LLM) стали свободно и убедительно формулировать ответы, но вместе с этим они часто выдают неправильную информацию или используют грамматически корректные, но бессмысленные формулировки.

Японские ученые предположили, что работа таких моделей похожа на поведение людей с афазией — речевым расстройством, вызванным поражением определенных зон головного мозга. Слух у таких пациентов сохраняется. При этом нарушении человек может бегло и много говорить, но его речь не имеет смысла или сложна для восприятия.

Чтобы проверить гипотезу, исследователи проанализировали работу больших языковых моделей — GPT-2, LLaMA-3.1 и ALBERT. Группа ученых определила, как часто модель может переходить из стабильного состояния в хаотичное и насколько долго она остается в определенном шаблоне. Затем авторы сравнили поведение моделей и головного мозга пациентов с афазией. Оказалось, что то, как цифровая информация перемещается и обрабатывается в рамках моделей ИИ, полностью соответствует работе мозга людей с некоторыми видами афазии, связанными с нарушениями речи.

«Мы не утверждаем, что у моделей ИИ "поврежден мозг". Но у них может быть некий жесткий внутренний шаблон, который ограничивает их гибкость в использовании накопленных знаний, как при афазии. Смогут ли будущие модели преодолеть это ограничение, еще предстоит выяснить, но понимание этих внутренних параллелей может стать первым шагом на пути к более "умному" и надежному ИИ», — рассказал Такамицу Ватанабе, соавтор исследования из Токийского университета, Япония.

Новые данные позволят точнее диагностировать афазию не только по речи пациента, но и по его мозговой активности, а также улучшить архитектуру больших языковых моделей.

Подписывайтесь на InScience.News в социальных сетях: ВКонтакте, Telegram, Одноклассники.