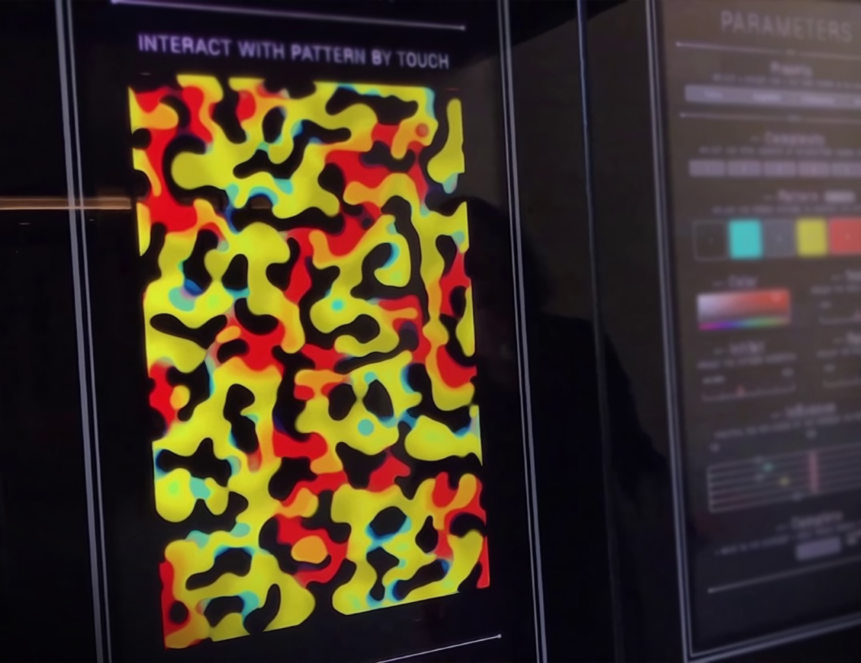

Российские ученые показали, что приводящие к ошибкам в работе нейронных сетей при распознавании изображений паттерны являются распространенными в природе Тьюринг-подобными паттернами. В будущем это поможет защитить системы распознавания. Результаты исследования были представлены авторами на 35-й Конференции AAAI по искусственному интеллекту (AAAI-21). Препринт статьи доступен на сервере arXiv.org.

Современные глубокие нейронные сети уже способны успешно распознавать и классифицировать изображения. Но при этом они все еще не умеют противостоять так называемым адверсальным атакам, при которых создаются мелкие искажения на изображении, приводящие к ошибкам нейронной сети. Некоторые из подобных атак — универсальные, то есть при их подаче на вход сети они неизменно нарушают ее работу. Это создает серьезную угрозу для безопасности. Например, в 2018 году группа авторов опубликовала препринт, в котором они описали, как можно запутать беспилотный автомобиль. Для этого было достаточно заставить его воспринимать обычную уличную рекламу с логотипом как дорожный знак.

Большинство современных систем защиты обойти несложно, что усугубляет проблемы с безопасностью. Ученые из Сколковского института науки и технологий исследовали теорию, согласно которой существует связь между универсальными адверсальными возмущениями (UAP) и классическими паттернами Тьюринга, названными в честь знаменитого английского математика Алана Тьюринга. Именно он впервые ввел понятие «паттерна», лежащего в основе многих узоров в природе, например полос и пятен в окраске животных.

Природа и механизм адверсальных возмущений до сих пор остаются слабоизученными. «Это долгая история игры в кошки-мышки между нападающим и обороняющимся. Одной из причин, по которой от таких атак до сих пор нет эффективной защиты, — это недостаточность теоретической проработки. Выполнив это исследование, мы сделали еще один шаг в понимании необычных свойств UAP с помощью паттернов Тьюринга, которые имеют под собой прочную теоретическую базу. В перспективе это позволит построить теорию адверсальных примеров», — рассказал один из авторов работы, профессор Центра Сколтеха по научным и инженерным вычислительным технологиям для задач с большими массивами данных Иван Оселедец.

Ранее уже было показано, что естественные паттерны Тьюринга, например полосы у рыб, могут «обманывать» нейронную сеть. Теперь ученым из Сколтеха удалось не только показать связь, но и описать способы генерации новых атак. «Самый простой способ добиться устойчивости модели с помощью паттернов — добавлять их к изображениям и обучать сеть на искаженных изображениях», — отметил Оселедец.

Подписывайтесь на InScience.News в социальных сетях: ВКонтакте, Telegram, Одноклассники.